Normalisation de la sécurité et des pratiques de l’IA : Assurer un avenir responsable

L’intelligence artificielle (IA) se distingue comme une technologie disruptive dans le paysage numérique d’aujourd’hui et est en constante évolution depuis des décennies. Mais la vraie révolution pour le grand public date de fin 2022 avec l’accés à chatGPT de l’entreprise openAI.

L’engouement autour de ChatGPT, Dall-E, Google Bard et des centaines d’autres outils d’IA qui rivalisent ne cesse de croître, tandis que les grandes entreprises technologiques continuent de faire progresser leurs modèles de langage de grande envergure (LLM) pour » penser comme des humains ».

Ce n’est que le début de l’accès via des applications depuis un ordinateur et smartphone, pour ceux qui s’intéressent à ces nouvelles fonctions.

Des recommandations de contenu personnalisées à la conduite de véhicules autonomes, l’IA fait des incursions significatives dans notre vie quotidienne.

Cependant, comme toutes les technologies révolutionnaires, l’IA présente ses propres défis, en particulier en matière de sécurité et de considérations éthiques.

Pourquoi la sécurité de l'IA est-elle nécessaire ?

La sécurité de l’IA est cruciale parce que, à mesure que les systèmes d’intelligence artificielle deviennent plus puissants et intégrés à différents aspects de notre vie, il existe un potentiel de conséquences involontaires ou de mauvais usage.

Si l’IA n’est pas correctement conçue, supervisée ou contrainte, elle pourrait commettre des erreurs ayant des implications à grande échelle, propager des biais ou être exploitée à des fins malveillantes.

NB : Voir Les « Trois lois de la robotique » d’Isaac Asimov ( article a venir )

Garantir la sécurité de l’IA contribue à favoriser la confiance, à préserver les valeurs humaines et à faire en sorte que le déploiement de ces systèmes apporte des avantages sociétaux sans poser de risques indus.

Il s’agit d’une approche proactive visant à anticiper, comprendre et atténuer les problèmes potentiels avant qu’ils ne se manifestent à grande échelle.

L’impératif de la normalisation qui fait débat dans les pays et institutions.

L’IA reste en bien des aspects un « Far West », avec des méthodologies diverses, des niveaux de transparence variables et parfois une responsabilité discutable.

Sans normalisation, l’IA pourrait continuer à agir de manière imprévisible, comme un chien errant semant le chaos dans tous les domaines de notre vie, en empiétant sur notre vie privée ou en violant nos droits de protection des données.

Il est nécessaire de créer des normes pour guider le développement et l’utilisation de l’IA.

NB : Voir Le « complexe de Frankenstein » ( article a venir )

Les trois raisons pour lesquelles je pense que la normalisation de l'IA est nécessaire :

Manque de cohérence

Différentes organisations peuvent mettre en œuvre l’IA avec des normes variables, ce qui conduit à des résultats imprévisibles. La normalisation garantira que les organisations respectent des normes particulières de qualité et de mesures de sécurité lors du développement ou de l’utilisation de l’IA.

Préoccupations éthiques

Sans lignes directrices universellement acceptées, l’IA pourrait être utilisée de manière préjudiciable ou perpétuer des biais. Un animal sauvage doit être mis en cage pour éviter de nuire au grand public.

Problèmes de sécurité

Surtout dans des applications critiques comme les soins de santé ou les transports, des pratiques d’IA incohérentes peuvent entraîner des risques importants pour la sécurité.

Le boom exponentiel de l’intelligence artificielle a moins de 10 ans.

Beaucoup de recherche et de développement, donc de fonds, ont été consacrés à l’IA, ce qui a révélé les divers potentiels de l’IA dans plusieurs domaines.

Exemple : Santé et médecine, automobile et conduite autonome, finance et service bancaire, e-commerce et marketing, logistique, industrie manufacturière, cabinet de conseil.

Transparence et explicabilité

À mesure que les modèles d’IA deviennent plus complexes, comprendre comment ils parviennent à prendre des décisions est primordial.

La normalisation des moyens de rendre l’IA « explicable » renforcera la confiance des parties prenantes. Exemple : Dans le domaine de la santé, si un système d’IA pose un diagnostic à un patient, les médecins devraient comprendre comment cette décision a été prise.

Peut-être que l’outil d’IA devrait présenter une étude de cas plutôt que de simplement générer une décision isolée.

Biais et équité

Les modèles d’IA peuvent involontairement perpétuer des biais sociaux présents dans les données d’entraînement. Les normes devraient garantir que les systèmes d’IA sont équitables et ne renforcent pas les préjugés.

Exemple : Les outils d’IA pour le recrutement ne devraient pas favoriser les candidats en fonction de leur genre, de leur race ou d’autres facteurs non pertinents. Cependant, cela peut également dépendre de la qualité des données sur lesquelles l’IA a été formée.

Robustesse et sécurité

Les systèmes d’IA doivent être résilients aux attaques malveillantes et fonctionner de manière fiable dans des conditions variées.

Exemple : Les véhicules autonomes doivent être imperméables aux attaques adverses visant à tromper leurs systèmes de vision. Les hacks sont le cauchemar des constructeurs automobiles.

Confidentialité

Comme l’IA nécessite souvent de vastes quantités de données, la normalisation de la manière dont l’IA respecte la vie privée des utilisateurs est primordiale.

Exemple : Le marketing personnalisé basé sur l’IA ne doit pas compromettre les données privées d’une personne.

Déploiement et surveillance

La surveillance après le déploiement est essentielle pour garantir que les systèmes d’IA fonctionnent comme prévu dans le monde réel.

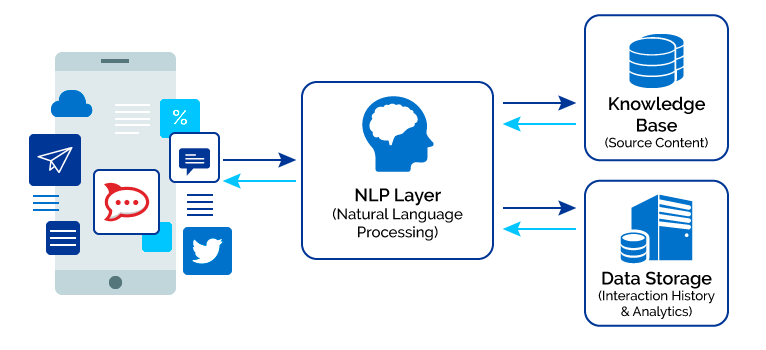

Exemple : Un chatbot d’IA pour le support client doit être régulièrement surveillé et mis à jour pour traiter efficacement de nouvelles demandes.

Perspectives 2030

Collaboration internationale

À mesure que l’IA transcende les frontières, des organismes internationaux pourraient émerger, similaires à l’Organisation mondiale de la santé (OMS), pour superviser la sécurité et les pratiques mondiales de l’IA.

Certifications et badges

Les organisations pourraient recevoir des certifications pour avoir respecté les normes de l’IA, similaires aux certifications ISO dans d’autres industries.

Partenariats public-privé

Les gouvernements et les entreprises privées pourraient collaborer en combinant la supervision réglementaire avec la praticité sur le terrain.

Évolution avec les progrès de l'IA

À mesure que l’IA avance, les normes devront être régulièrement réexaminées et révisées pour rester pertinentes.

Initiatives éducatives

Les universités et les institutions pourraient proposer des cours et des programmes axés sur les pratiques normalisées de l’IA, inculquant ces valeurs aux futurs praticiens de l’IA.

Chez Formatom nous collaborons avec l’université de Genève qui propose des parcours supérieurs pour former les entreprises aux enjeux de l’IA .

Réponses